В интернете уже очень давно популярны автонаполняемые сайты. Вот об этих сайтах, их создании, особенностях и о возможных проблемах с ними мы сейчас и расскажем. А также расскажем о нашем эксперименте.

Что такое автонаполняемые сайты?

Автонаполняемый сайт — это сайт, в котором контент (новости, статьи) публикуется в автоматическом режиме. Информация для публикации берётся с других сайтов без изменений или с какими-либо корректировками (от совсем минимальных и вплоть до полного рерайта).

Для чего их создают?

Если кратко, то для продажи ссылок в том или ином виде. Вебмастера заинтересованы в дополнительном доходе (согласитесь, кто не хотел бы заработать больше?). Особенно если этот доход будет относительно пассивным. Потому и появилось подобное направление заработка путем создания одного или нескольких сайтов для продажи ссылок. Проблема увеличения числа страниц решалась через парсинг новостей и иного контента на других сайтах с публикацией на сайте вебмастера. И здесь возможны несколько вариантов, как вебмастера зарабатывают на продаже ссылок:

- Вебмастер подключается к биржам арендных ссылок и предоставляет свой сайт для продажи мест под такие ссылки;

- Вебмастер подключается к биржам вечных ссылок и размещает заказные статьи;

- Вебмастер или SEO-специалист самостоятельно ищет клиентов и публикует на своих сайтах их статьи с внешними ссылками.

В первом случае участие владельца сайта не требуется. Размещение ссылок происходит в автоматическом режиме. Во втором случае вебмастер должен отслеживать поступающие с биржи вечных ссылок заявки и публиковать статьи заказчиков вручную. В третьем случае заявки приходят не из бирж, а из других источников (обычно это форумы, Kwork и т.д.)

К слову, SEO специалисты достаточно часто создают сайты с целью продвижения сайтов своих клиентов. В ряде случаев эти сайты наполняются автоматически. То есть создаётся несколько сайтов, на них настраивается парсинг и публикация контента с разных источников. И дальше на этих сайтах размещаются ссылки на веб-ресурсы клиентов, которые нужно продвигать.

Иногда такие сайты создают в качестве эксперимента. В интернете есть несколько таких историй-кейсов, где описываются эксперимент и наглядно показывают результаты.

На чем создают автонаполняемые сайты?

Чаще всего на бесплатных CMS. Среди самых популярных — WordPress и Joomla. Субъективно WordPress будет проще и удобнее, но это уже дело привычки.

Что требуется для создания такого сайта?

Вам потребуется следующее:

- определиться с тематикой сайта. Она может быть одна (например, только о ремонте) или несколько (например, финансы, политика и т.д.);

- подобрать сайты, откуда вы будете брать контент;

- арендовать хостинг;

- установить CMS на хостинг (на многих хостингах это можно сделать за несколькок ликов, но лучше ставить CMS вручную, так вы полностью все контролируете);

- установить плагин для парсинга контента и настроить его (обычно здесь возникают сложности);

- подобрать доменное имя (либо новое, либо «б/у», то есть с историей);

- запустить сайт, наполнить его контентом, настроить системы аналитики, позаботится об оптимизации новых страниц, отправить сайт на индексацию.

Звучит не сложно, но всегда будут какие-либо проблемы. Вот о них мы поговорим далее.

Проблемы с автонаполняемыми сайтами

На самом деле проблема с такими сайтами достаточно много. Кратко их перечислим и далее разберём подробно:

- Молодой домен

- История домена

- Отсутствие внешних ссылок

- Неуникальный контент и проблемы с переводом иностранных статей

- Алгоритмы поисковых систем

1. Молодой домен

Возраст доменного имени влияет на доверие к сайты со стороны поисковых систем. К тому же первые полгода (а то и больше) сайт находится в своеобразной «песочнице». Поисковые системы с недоверием относятся к новому сайту, у него могут быть проблемы с добавлением новых страниц в индекс.

Потому просто будьте готовы к подобному развитию событий. Но если через 1-2 месяца в индекс не попала ни одна страница, то это плохо.

2. История домена

Крайне важно перед покупкой домена посмотреть его историю по веб-архиву. Есть вероятность что вы купите домен, который уже использовался для продажи ссылок и попал под фильтры поисковых систем. Либо же домен когда-то использовался для продвижения сайтов интим-тематики (через редирект), на сайте был размещён контент запрещённого характера и т.д.

Такая история домена может поставить крест на сайте. В общем, историю домена лучше изучить заранее.

Покупать домен, которым владели ранее, вполне можно. Возможно на этом домене имеются внешние ссылки, что очень неплохо (по нашему опыту, домены с положительной историей и внешними ссылками быстрее заходят в индекс поисковых систем). Но и сами внешние ссылки следует изучить. Множество спамных ссылок не будет хорошим сигналом для покупки такого домена.

3. Отсутствие внешних ссылок

Внешние ссылки — один из значимых факторов ранжирования сайтов. У молодых сайтов, домены которых куплены впервые, внешних ссылок попросту нет. И над их получением придётся поработать.

Отчасти все будет зависеть от тематики вашего сайта. Если у вас сайт, например, спортивной тематики, то и внешние ссылки желательно чтобы были с других спортивных сайтов. Это, конечно, идеальный вариант.

Как ещё можно получить внешние ссылки:

- зарегистрироваться в каталогах сайтов;

- поискать сайты, где можно разместить пресс-релиз;

- если у вас есть аккаунты на форумах, то разместите ссылку в профиле и в подписи;

- поискать подходящие сайты на биржах вечных ссылок;

- посмотреть сайты на биржах арендных ссылок.

При этом не надо ставить во главу угла внешние ссылки. Это один из инструментов, но он не главный. Первые полгода можно ставить внешние ссылки по минимуму (например, по 1-2-3 ссылки в неделю, а то и реже). Помните, контент — всему голова. И с ним также бывают проблемы.

4. Неуникальный контент

Это, пожалуй, самая главная проблема автонаполняемых сайтов. Вы берете чужой контент и размещаете его на своём сайте. А поисковые системы борются с таким «воровством». Как вариант, брать зарубежные статьи и делать их автоматический перевод с помощью различных сервисов. Какое будет качество перевода — это уже зависит от сервиса. Правда потребуется подключать уже несколько платных сервисов.

Кстати, по похожей схеме работает сайт Adme с той лишь разницей, что вместо парсинга они нанимают людей, которые берут с зарубежных сайтов идеи и контент, делают перевод и публикуют на сайте после проверки редактором.

Другой вариант — брать контент с отечественных сайтов и делать его рерайт. Во многих парсерах контента есть интеграция с сервисами-синонимайзерами. По опыту, качество такой синонимизации порой не блещет. Текст статьи на русском языке может легко и просто стать старославянским после работы такого синонимайзера. Читать такое сложно, но уникальность все же будет повыше.

Третий вариант — комбинировать первые два варианта. Берете статьи с иностранных сайтов, переводите их и сразу же прогоняете через синонимайзер. Этот способ мы не пробовали, но видели положительные отзывы. Каков результат — без понятия.

Четвёртый способ — полное или частичное редактирование контента. То есть парсер берет информацию с сайтов-источников, публикует её на вашем сайте. А затем вы вручную меняете текст статей, делая их уникальными. Такой способ требует времени, но он даёт результаты.

Пятый способ — часть контента оставить как есть, то есть не уникальным (или же пропускать его через сервис-синонимайзер), а часть — редактировать, заказать у копирайтеров, написать самому. Способ трудоёмкий и затраты, но уникальные статьи могут быстрее начать приносить трафик. Так можно сделать несколько десятков лонгридов (то есть длинных статей, отвечающих на какой-то запрос пользователя), оптимизированных под высокочастотные запросы, «прокачать» эти статьи внутренними и внешними ссылками, и попытаться занять неплохие позиции.

5. Алгоритмы поисковых систем

Поисковые системы любят уникальные материалы, которые могут решить проблему пользователей, дать ответ на интересующие их вопросы. Для поисковых систем это вопрос жизни и смерти в прямом смысле. Если человек не нашёл в Google ответа, не решил свою проблему, не нашёл сразу нужный и полезный сайт, то он уйдёт искать в Яндекс, Bing и т.д. Уходят пользователи — меньше аудитория. Меньше аудитория — меньше рекламодателей. И как следствие — меньше доход.

Вы пользуетесь Рамблером? Нет? Когда-то люди перестали им пользоваться, отдав предпочтение Яндексу и Google, и присковик ушел на задворки истории.

Потому поисковики и борются с ворованным контентом. «Ничего личного, просто бизнес».

Эксперимент с автонаполняемым сайтом

Мы провели небольшой эксперимент. Купили 2 доменных имени (сами домены мы не будем афишировать). Установили WordPress, взяли новостные шаблоны разных цветов.

Первый сайт сайт имеет абсолютно новый домен и практически полностью уникальный контент (за исключением нескольких новостных материалов). На этом сайте мы либо писали контент самостоятельно, стремясь сделать его удобным для чтения человеком и учитывая поисковые запросы, либо привлекали копирайтеров, которые делали статьи под наши требования. Дополнительно мы поработали над внешними ссылками и у сайта есть своя группа ВКонтакте.

Второй сайт — это полностью автонаполняемый сайт. Правда оговоримся — мы его все же постарались уникализировать. Во-первых, после парсинга и публикации новостей мы вручную меняли заголовки, делали перелинковку с другими страницами. Во-вторых, хотя бы раз — два раза в месяц мы публиковали какой-либо уникальный контент. И у этого сайта мы стремились сделать больше посадочных страниц, используя систему тегов WordPress (страницы тегов уникализировали с помощью метатегов и текстового описания на страницах). По внешним ссылкам мы работали совсем мало (буквально пара штук), а сам домен был «б/у» и имел с десяток внешних ссылок с разных источников (весьма, кстати, неплохих источников).

Ну и цель эксперимента — мы хотели посмотреть, как вообще будет работать автонаполняемый сайт, какие будут результаты, будут ли посетители в сравнении с сайтом, где контент полностью уникален и т.д.

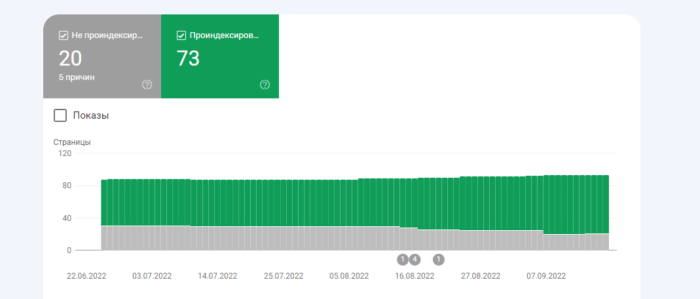

Индексирование. У первого сайта в индексе всего 73 страницы и 20 страниц вне индекса Google.

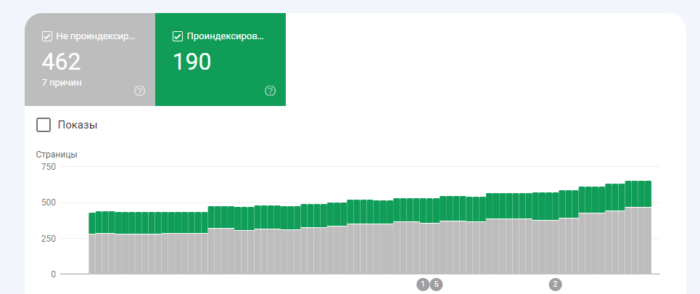

У второго сайта в индексе 190 страниц, а вне индекса Google уже 462 страницы. То есть Google весьма неохотно добавляет к себе в базы неуникальный контент.

Правда с индексированием первого сайта были большие проблемы. Новые статьи могли больше месяца просто не попадать в индекс Google. Со вторым сайтом старт был проще, Google оказался более дружелюбен к нему, но потом неуникальный контент перестал нравится поисковику.

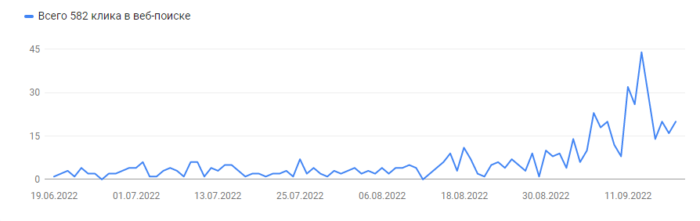

И, наконец, посещаемость. У первого (полностью уникального) сайта за три месяца 582 клика с Google-поиска.

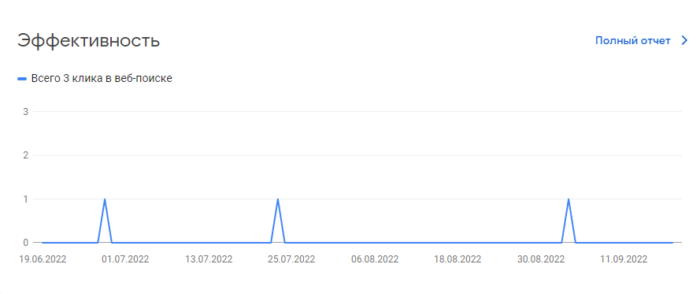

Посещаемость у второго (автоматически наполняемого) сайта составила… целых 3 клика с Google-поиска!

Не густо… Но первый сайт имеет небольшое преимущество по возрасту — домен был зарегистрирован примерно на 5 месяцев раньше второго. Поэтому эксперимент продолжается и мы будем публиковать его результаты на страницах нашего сайта.